在pandas中 求差集没有专门的函数。处理办法就是将两个dataframe追加合并,然后去重。

|

1

2

|

divident.append(hasthisyeardivident)nohasthisyeardivident = divident.drop_duplicates(subset='ts_code', keep=false, inplace=true, ignore_index=true) |

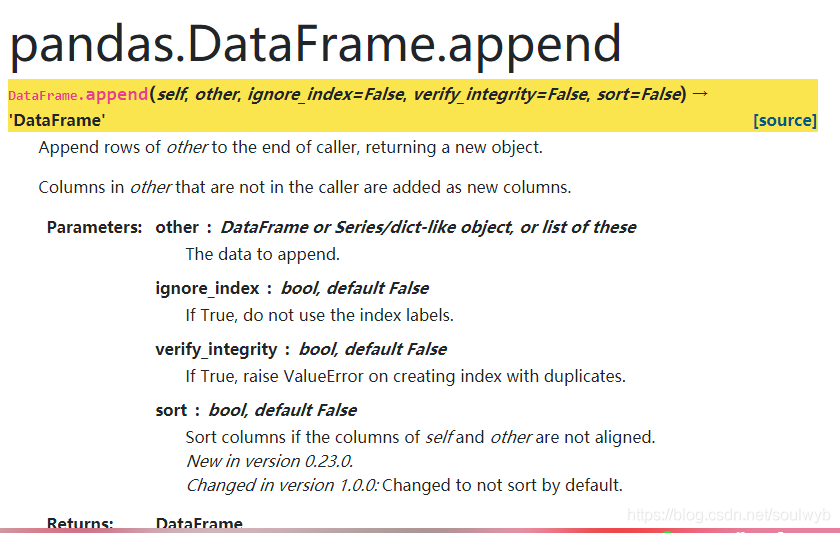

具体函数用法:

https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.dataframe.append.html#pandas.dataframe.append

https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.dataframe.drop_duplicates.html#pandas.dataframe.drop_duplicates

补充示例:pandas中两个dataframe的差集

在pandas中,两个dataframe的差集并没有直接的库内置方法,现在我们希望有一种方法,就像python中set内置的求差集一样,来找到两个dataframe的差集。

|

1

2

3

4

5

6

7

8

|

>>> a=set((1,2,3))>>> a{1, 2, 3}>>> b=set((2,3,4))>>> b{2, 3, 4}>>> a-b{1} |

上面代码片段是对set的内置求差集方法的回顾,现在我们希望能有类似的方法来找两个dataframe的差集。

解决思路是这样的:

对于有同样index的a,b两个dataframe,如果现在要求a对b的差集,那么可以(1)连续两次扩充a,使用append方法(2)然后使用drop_duplicates方法对a进行去重,并且参数keep=false。原理很简单,也很巧妙,连续扩充2次a,那么新扩充完后的dataframe中来自b的row肯定是重复的,去重时候,b全部被删除,与此同时,a中跟b重复的row也会顺带着被删除。

代码实现:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

>>> import pandas as pd>>> data_a={'state':[1,1,2],'pop':['a','b','c']}>>> data_b={'state':[1,2,3],'pop':['b','c','d']}>>> a=pd.dataframe(data_a)>>> b=pd.dataframe(data_b)>>> a state pop0 1 a1 1 b2 2 c>>> b state pop0 1 b1 2 c2 3 d>>> a=a.append(b)>>> a=a.append(b)>>> a state pop0 1 a1 1 b2 2 c0 1 b1 2 c2 3 d0 1 b1 2 c2 3 d>>> a.drop_duplicates(subset=['state','pop'],keep=false) state pop0 1 a |

到此这篇关于pandas dataframe求差集的示例代码的文章就介绍到这了,更多相关pandas dataframe求差集内容请搜索服务器之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持服务器之家!

原文链接:https://blog.csdn.net/soulwyb/article/details/104218907