大家好,我是小f~

很多人在学习数据分析的时候,肯定都会用到pandas这个库,非常的实用!

从创建数据到读取各种格式的文件(text、csv、json),或者对数据进行切片和分割组合多个数据源,pandas都能够很好的满足。

pandas最初发布于2008年,使用python、cython和c编写的。是一个超级强大、快速和易于使用的python库,用于数据分析和处理。

当然pandas也是有不足之处的,比如不具备多处理器,处理较大的数据集速度很慢。

今天,小f就给大家介绍一个新兴的python库——polars。

使用语法和pandas差不多,处理数据的速度却比pandas快了不少。

一个是大熊猫,一个是北极熊~

GitHub地址:https://github.com/ritchie46/polars

使用文档:https://ritchie46.github.io/polars-book/

polars是通过rust编写的一个库,polars的内存模型是基于apache arrow。

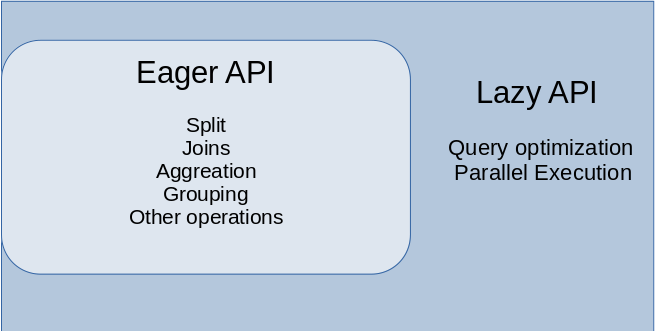

polars存在两种api,一种是eager api,另一种则是lazy api。

其中eager api和pandas的使用类似,语法差不太多,立即执行就能产生结果。

而lazy api就像spark,首先将查询转换为逻辑计划,然后对计划进行重组优化,以减少执行时间和内存使用。

安装polars,使用百度pip源。

|

1

2

|

# 安装polarspip install polars -i https://mirror.baidu.com/pypi/simple/ |

安装成功后,开始测试,比较pandas和polars处理数据的情况。

使用某网站注册用户的用户名数据进行分析,包含约2600万个用户名的csv文件。

文件已上传公众号,获取方式见文末。

|

1

2

3

4

|

import pandas as pddf = pd.read_csv('users.csv')print(df) |

数据情况如下。

此外还使用了一个自己创建的csv文件,用以数据整合测试。

|

1

2

3

4

|

import pandas as pddf = pd.read_csv('fake_user.csv')print(df) |

得到结果如下。

首先比较一下两个库的排序算法耗时。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

import timeitimport pandas as pdstart = timeit.default_timer()df = pd.read_csv('users.csv')df.sort_values('n', ascending=false)stop = timeit.default_timer()print('time: ', stop - start)-------------------------time: 27.555776743218303 |

可以看到使用pandas对数据进行排序,花费了大约28s。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

import timeitimport polars as plstart = timeit.default_timer()df = pl.read_csv('users.csv')df.sort(by_column='n', reverse=true)stop = timeit.default_timer()print('time: ', stop - start)-----------------------time: 9.924110282212496 |

polars只花费了约10s,这意味着polars比pandas快了2.7倍。

下面,我们来试试数据整合的效果,纵向连接。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

import timeitimport pandas as pdstart = timeit.default_timer()df_users = pd.read_csv('users.csv')df_fake = pd.read_csv('fake_user.csv')df_users.append(df_fake, ignore_index=true)stop = timeit.default_timer()print('time: ', stop - start)------------------------time: 15.556222308427095 |

使用pandas耗时15s。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

import timeitimport polars as plstart = timeit.default_timer()df_users = pl.read_csv('users.csv')df_fake = pl.read_csv('fake_user.csv')df_users.vstack(df_fake)stop = timeit.default_timer()print('time: ', stop - start)-----------------------time: 3.475433263927698 |

polars居然最使用了约3.5s,这里polars比pandas快了4.5倍。

通过上面的比较,polars在处理速度上表现得相当不错。

可以是大家在未来处理数据时,另一种选择~

当然,pandas目前历时12年,已经形成了很成熟的生态,支持很多其它的数据分析库。

polars则是一个较新的库,不足的地方还有很多。

如果你的数据集对于pandas来说太大,对于spark来说太小,那么polars便是你可以考虑的一个选择。

文件地址:

链接:https://pan.baidu.com/s/14ffnopomqe38rlbauq5w7w 密码:nfqv

以上就是python polars库的使用简介的详细内容,更多关于python polars库的使用的资料请关注服务器之家其它相关文章!

原文链接:https://mp.weixin.qq.com/s/jCcQCURDyPCvbPKDuRaxiw