概述

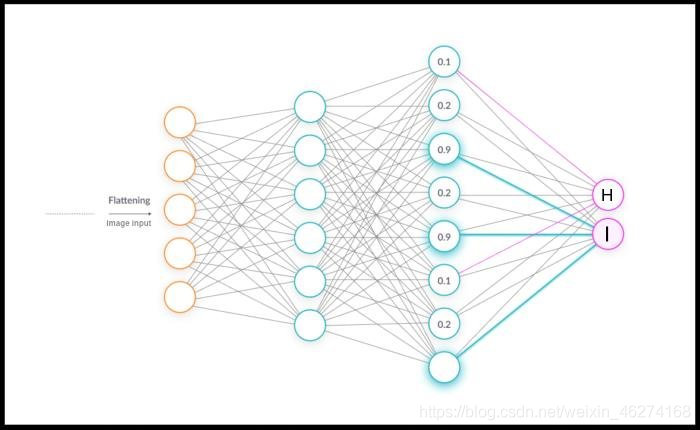

全链接层 (Fully Connected Layer) 会把一个特质空间线性变换到另一个特质空间, 在整个网络中起到分类器的作用.

keras.layers.Dense

keras.layers.Dense可以帮助我们实现全连接.

格式:

tf.keras.layers.Dense( units, activation=None, use_bias=True, kernel_initializer='glorot_uniform', bias_initializer='zeros', kernel_regularizer=None, bias_regularizer=None, activity_regularizer=None, kernel_constraint=None, bias_constraint=None, **kwargs )

| 参数 | 介绍 |

|---|---|

| units | 正整数, 输出空间维度 |

| activation | 激活函数, 若不指定, 则不适用激活函数 |

| use_bias | 布尔值, 该层是否使用偏置向量 |

| kernel_initializer |

kernel权值矩阵的初始化器 |

| bias_initializer | 偏执向量的初始化器 |

| kernel_regulaizer | 运用到偏执项的正则化函数 |

| bias_regularizer | 运用到偏执项的的正则化函数 |

| activity_regulatizer | 运用到层的输出正则化函数 |

| kernel_constrint |

运用到kernel权值矩阵的约束函数 |

| bias_constraint | 运用到偏执向量的约束函数 |

例子:

# 创建正态分布

x = tf.random.normal([256, 784])

# 创建全连接层, 输出为512

net = tf.keras.layers.Dense(512)

out = net(x)

# 调试输出

print("w:", net.kernel.shape)

print("b:", net.bias.shape)

输出结果:

w: (784, 512)

b: (512,)

keras.Squential

Squential (序列模型) 是各层次之间依次顺序的线性关系. 模型结构通过一个列表来制定.

格式:

tf.keras.Sequential( layers=None, name=None )

参数:

- layers: 添加的层

- name: 数据名称

例子:

# 创建正态分布 x = tf.random.normal([256, 784]) # 建立网络模型 model = tf.keras.Sequential([ tf.keras.layers.Dense(256, activation="relu"), tf.keras.layers.Dense(128, activation="relu"), tf.keras.layers.Dense(10, activation="relu"), ]) # 传入x model(x) # 调试输出权重和偏置顶名字和形状 for p in model.trainable_variables: print(p.name, p.shape)

输出结果:

w: (784, 512)

b: (512,)

dense_1/kernel:0 (784, 256)

dense_1/bias:0 (256,)

dense_2/kernel:0 (256, 128)

dense_2/bias:0 (128,)

dense_3/kernel:0 (128, 10)

dense_3/bias:0 (10,)

到此这篇关于一小时学会TensorFlow2之全连接层的文章就介绍到这了,更多相关TensorFlow2全连接层内容请搜索服务器之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持服务器之家!

原文链接:https://iamarookie.blog.csdn.net/article/details/117838748