前言

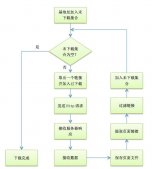

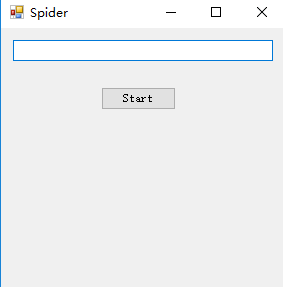

作为一个新手,最近在学习c#,自己折腾弄了个简单的小说爬虫,实现了把小说内容爬下来写入txt,还只能爬指定网站。

第一次搞爬虫,涉及到了网络协议,正则表达式,弄得手忙脚乱跑起来效率还差劲,慢慢改吧。下面话不多说了,来一起看看详细的介绍吧。

爬的目标:http://www.166xs.com/xiaoshuo/83/83557/

一、先写httpwebrequest把网站扒下来

这里有几个坑,大概说下:

第一个就是记得弄个代理ip爬网站,第一次忘了弄代理然后ip就被封了。。。。。

第二个就是要判断网页是否压缩,第一次没弄结果各种转码gbk utf都是乱码。后面解压就好了。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

|

/// <summary> /// 抓取网页并转码 /// </summary> /// <param name="url"></param> /// <param name="post_parament"></param> /// <returns></returns> public string httpget(string url, string post_parament) { string html; httpwebrequest web_request = (httpwebrequest)webrequest.create(url); web_request.timeout = 30000; web_request.method = "get"; web_request.useragent = "mozilla/4.0"; web_request.headers.add("accept-encoding", "gzip, deflate"); //web_request.credentials = credentialcache.defaultcredentials; //设置代理属性webproxy------------------------------------------------- webproxy proxy = new webproxy("111.13.7.120", 80); //在发起http请求前将proxy赋值给httpwebrequest的proxy属性 web_request.proxy = proxy; httpwebresponse web_response = (httpwebresponse)web_request.getresponse(); if (web_response.contentencoding.tolower() == "gzip") // 如果使用了gzip则先解压 { using (stream stream_receive = web_response.getresponsestream()) { using (var zip_stream = new gzipstream(stream_receive, compressionmode.decompress)) { using (streamreader stream_reader = new streamreader(zip_stream, encoding.default)) { html = stream_reader.readtoend(); } } } } else { using (stream stream_receive = web_response.getresponsestream()) { using (streamreader stream_reader = new streamreader(stream_receive, encoding.default)) { html = stream_reader.readtoend(); } } } return html; } |

二、下面就是用正则处理内容了,由于正则表达式不熟悉所以重复动作太多。

1.先获取网页内容

|

1

2

|

iwebhttprepository webhttprepository = new webhttprepository(); string html = webhttprepository.httpget(url_txt.text, ""); |

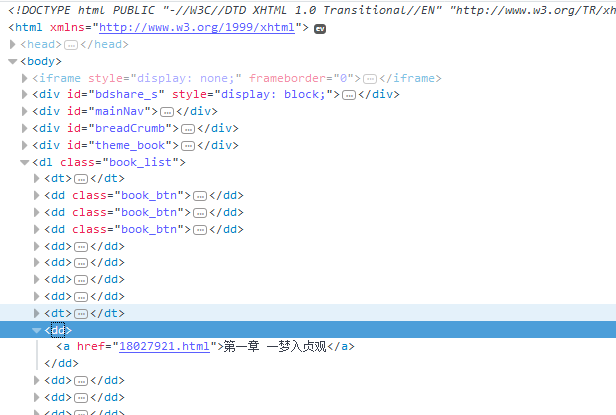

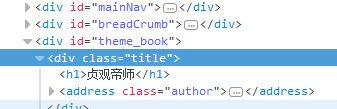

2.获取书名和文章列表

书名

文章列表

|

1

2

3

4

5

6

7

8

|

string novel_name = regex.match(html, @"(?<=<h1>)([\s\s]*?)(?=</h1>)").value; //获取书名 regex regex_menu = new regex(@"(?is)(?<=<dl class=""book_list"">).+?(?=</dl>)"); string result_menu = regex_menu.match(html).value; //获取列表内容 regex regex_list = new regex(@"(?is)(?<=<dd>).+?(?=</dd>)"); var result_list = regex_list.matches(result_menu); //获取列表集合 |

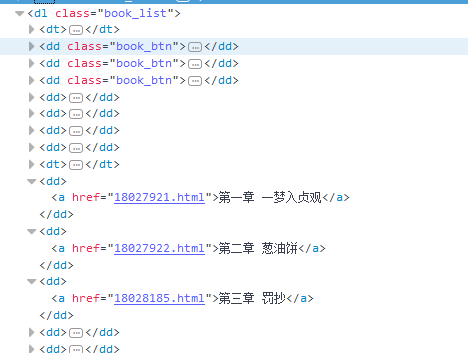

3.因为章节列表前面有多余的<dd>,所以要剔除

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

int i = 0; //计数 string menu_content = ""; //所有章节 foreach (var x in result_list) { if (i < 4) { //前面五个都不是章节列表,所以剔除 } else { menu_content += x.tostring(); } i++; } |

4.然后获取<a>的href和innerhtml,然后遍历访问获得内容和章节名称并处理,然后写入txt

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

|

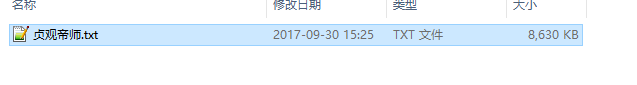

regex regex_href = new regex(@"(?is)<a[^>]*?href=(['""]?)(?<url>[^'""\s>]+)\1[^>]*>(?<text>(?:(?!</?a\b).)*)</a>"); matchcollection result_match_list = regex_href.matches(menu_content); //获取href链接和a标签 innerhtml string novel_path = directory.getcurrentdirectory() + "\\novel\\" + novel_name + ".txt"; //小说地址 file.create(novel_path).close(); streamwriter write_content = new streamwriter(novel_path); foreach (match result_single in result_match_list) { string url_text = result_single.groups["url"].value; string content_text = result_single.groups["text"].value; string content_html = webhttprepository.httpget(url_txt.text + url_text, "");//获取内容页 regex rege_content = new regex(@"(?is)(?<=<p class=""book_text"">).+?(?=</p>)"); string result_content = rege_content.match(content_html).value; //获取文章内容 regex regex_main = new regex(@"( )(.*)"); string rsult_main = regex_main.match(result_content).value; //正文 string screen_content = rsult_main.replace(" ", "").replace("<br />", "\r\n"); write_content.writeline(content_text + "\r\n");//写入标题 write_content.writeline(screen_content);//写入内容 } write_content.dispose(); write_content.close(); messagebox.show(novel_name+".txt 创建成功!"); system.diagnostics.process.start(directory.getcurrentdirectory() + \\novel\\); |

三、小说写入成功

总结

以上就是这篇文章的全部内容了,希望本文的内容对大家的学习或者工作具有一定的参考学习价值,如果有疑问大家可以留言交流,谢谢大家对服务器之家的支持。

原文链接:http://www.cnblogs.com/xinyibufang/p/7615400.html