【导读】

「傲腾™ 持久内存为PayPal带来的优异成绩,足以让任何想突破“内存墙”的企业跃跃欲试。」

如果问起是什么在支撑人工智能发展,算力、算法、数据三要素会被反复提及。

看似是:算法模型的爆发式成长和数据的爆炸式增速都远超算力的发展,算力应该是这三要素中的瓶颈。

但这里其实漏了个知识点,一个至关重要的因素往往会被忽视,那就是存储。

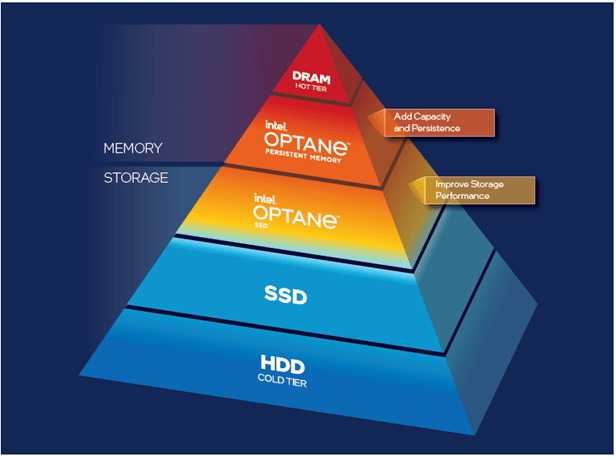

说到底还是硬件的问题,传统内存-存储技术的升级步伐(带宽、读写速度)一直都远远滞后于算力的提升,因此形成了性能层面上的内存墙。

尽管如此,如今的大数据和AI应用还是会尽力把更多热数据存入距算力更近、性能相对也更高的内存中,但DRAM内存容量有限且扩展成本太高,因此在容量层面形成了同样明显的内存墙问题——这也将是我们在下文中主要讨论的内存墙问题,这就不可避免地影响了AI技术的演进与落地应用,尤其是在大模型出现后。

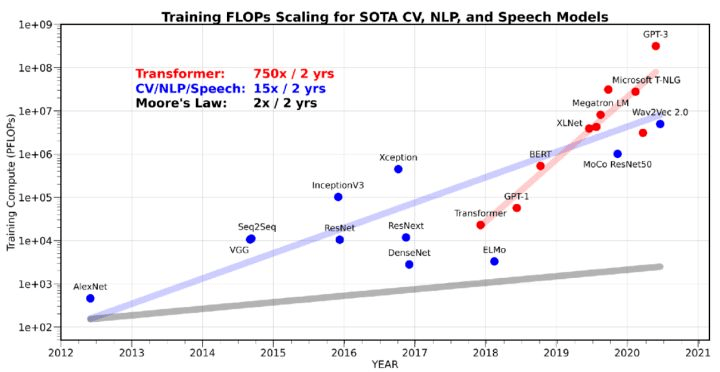

图说:蓝线代表目前CV,NLP和语音领域的SOTA模型,其训练的浮点数运算量(以 FLOPs为衡量单位)平均每两年翻15倍,红线代表的Transformer模型,其模型运算量更是平均每两年翻750倍。但灰线所示的,依然遵循摩尔定律的内存增长仅为平均每两年翻2倍。

来源:https://medium.com/riselab/ai-and-memory-wall-2cb4265cb0b8

以金融业为例,它一直被称为AI理想的应用落地领域之一,因为该行业保存着最为完善的历史数据,方便展开数字化、智能化。

但正是这种天然的优势使其在AI实践中会更早遭遇容量上的内存墙问题。

这是因为金融数据自身具备海量、高维和稀疏特性,以及金融AI应用对实时性的强烈需求,使得在金融领域中“内存容量不足”出现的几率及带来的影响也会被成倍放大。

通过人工智能来进行反欺诈检测就是金融界在智能化时代的一大关键创新,同样它也是会面对内存墙挑战的核心场景之一。

在其进行风险防控的过程中,防控窗口期经常稍纵即逝,因此它必须将尽可能多的数据导入内存来进行更为实时的处理和分析,如果内存容量受限无法担此重任,就可能会影响到检测效率,也意味着对风险失去防范和及时发现及纠正的机会。

一些业内人士甚至认为,如果无法有效解决内存墙问题,那么包括金融AI在内的各类AI方案,都可能会面临其商用化落地之路上的一大绊脚石。

解决方案不少,为何傲腾™ 持久内存成了突破内存墙的金刚钻?

作为全球最主流的在线支付、交易系统之一,PayPal一直都将欺诈预防能力作为其金融业务体系的重要保障,并拥有远低于行业平均水平的欺诈交易率,但尽管如此,PayPal依然会在这方面遭受每年超 10 亿美元的损失。

为了实时识别新出现的欺诈模式,PayPal早早就上马了一个具备强大欺诈预防模型的实时决策平台,但在需要处理和分析的数据持续暴增后,这个平台还是撞上了内存墙问题:

随着其IT基础设施上的总体数据以过百PB为基础并以每年32%的比例增加,其反欺诈决策平台的数据量也在逐年增长,特别是主索引的规模也在不断扩大,一旦存储它的各节点的内存容量用尽,那就意味着平台运作中特别注意的实时性会受到影响,进而也会影响欺诈预防和检测的效率。

对此,最直截了当的解决办法就是堆DRAM内存条,扩展内存容量。

不过,在SpaceX有望把飞向太空的成本拉低到数十美元/公斤的今天,告诉用户因为DRAM内存很贵,所以需要为新系统多付一大沓账单的情景显然并不美好。

此外,这样堆内存的效率也并不理想,因为受限硬件设计,用于企业级的DRAM单条容量如今还是多以32GB和64GB为主,128GB已经是妥妥难得一见的“高富帅”了,加上主流服务器内存的插槽有限,就算全插128GB型号,扩展后的总容量亦不乐观。

可能有人会提议,要不咱换到GPU平台试试?

这个想法其实比堆内存条更糟,因为对于非常倚重高并发、低时延数据交互的决策类或推荐类AI应用来说,GPU平台的内存(显存)容量更低且扩展性更差,就更不用说数据在CPU与GPU之间交换走的PCIe接口效率问题了。

堆料不行,改弦更张也不行,那么如何破局内存墙?

答案就是:还是要扩展CPU内存子系统的容量,但却不是使用DRAM,而是要用持久内存,用英特尔® 傲腾™ 持久内存。

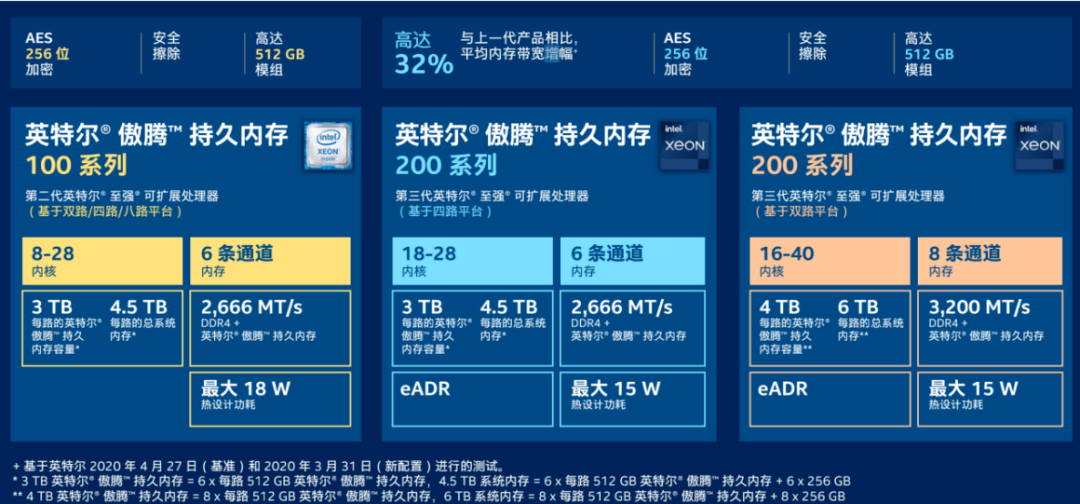

个中原因很简单:傲腾™ 持久内存能在输出接近DRAM性能的同时,提供数倍于其的容量,单条最高目前已能达到512GB,用它来扩展内存容量,突破TB就是小菜一碟——如果是与第三代英特尔® 至强® 可扩展处理器搭配的话,在一台双路服务器上仅仅是计算插装傲腾™ 持久内存的容量,就能带来8TB的增幅。

图说: 性能接近于DRAM的英特尔® 傲腾™ 持久内存

正好很巧的是,PayPal于2015年就开始主要采用来自Aerospike的数据库技术,而Aerospike正是最早支持英特尔® 傲腾™ 持久内存的数据库厂商之一。其创新的混合内存架构(Hybrid Memory Architecture,HMA)经过优化,不但能帮助PayPal在其反欺诈决策平台的节点中顺利部署傲腾™ 持久内存,而且还可以将体量越来越大的主索引存入其中,而非DRAM中。

于是,挡在主索引存储容量扩展道路上的内存墙,就这样轰然倒下。

效果真香!PayPal兼得容量、成本、性能和数据恢复加速收益

PayPal做出的选择效果如何?咱们用数字说话。

在采用傲腾™ 持久内存加持的 Aerospike 实时数据平台后,PayPal 基于其 2015 年的欺诈数据量和此前使用的平台为基准做了一个评估,它发现新方案可以将其欺诈计算的服务级别协议 (SLA) 遵守率从 98.5% 提升到 99.95%,漏查的欺诈交易量降到约为原来的 1/30。

与这两个核心数据相伴随的,还有更多降本增效的数据,例如与先前的基础设施相比,新方案使用的服务器总数量可以减少近 90%(从 1024 台减少到 120 台),以致相关硬件占用空间可减到约为原来的 1/8;又比如预计硬件成本可以从1250万美元降到350万美元,生生省掉了2/3的成本;再如新方案的吞吐量可增至原来的 5 倍,即每秒事务处理量从 20 万提升到 100 万等等。

更大、也更重磅的惊喜其实还在后面,PayPal发现傲腾™ 持久内存天生具备的数据持久性优势对于其数据恢复能力的强化至关重要。

原先它将主索引存在断电就会丢掉所有数据的DRAM里时,系统重启后需要从更慢的存储设备中扫描数据以便在DRAM中重建索引,而在新方案的支持下把主索引存入持久内存后并设置数据持久化后,整个系统就可以在非常短的时间内恢复并重新联机。

至于有多快?大概是将重建索引的时间从原来的59分钟缩短到现在的4分钟,用时变成原来的约1/12!

以上这些多重收益汇总起来,PayPal的反欺诈实时决策平台就迎来了春天:

即便有32%年数据增长率的压力,新平台也依然可以实现经济高效的扩展,并使PayPal保持99.95%的欺诈计算SLA遵守率,实现更短的节点重启时间、更强的查询性能和数据一致性,并保持全天候的高可用性(99.99%的运行时间)。

还没有One for All方案,但这一款你依然值得拥有

看到PayPal的实战效果后,你是不是也在跃跃欲试了?

先别急,如果你的应用也是决策或推荐类的AI应用,且主要是推理,特别是在CPU平台上做推理,那么基于傲腾™ 持久内存的方案可能还真是能帮到你突破内存墙的一个选择。

但如果你面临的,是基于GPU平台训练AI模型时被显存卡脖子的问题,那么最新走红的Colossal-AI可能才是你需要考虑和尝试的方向。

其实这种情况也表明,面向内存墙,现在整个产业界还远远没有到能够拿出一个One for All方案的时刻。要解决这个问题,大家还要做好 “路漫漫其修远兮,吾将上下而求索”的准备。

最后,让我们再说说那些与基于傲腾™ 持久内存的方案比较对路的应用场景和用户,他们其实还是值得试上一试的。

图说:英特尔® 至强® 可扩展处理器与英特尔® 傲腾™ 持久内存的搭配组合

毕竟,目前与这款持久内存产品搭档的主力,是英特尔内置了AI加速能力的第三代至强® 可扩展处理器,这对算力+内存的新产品组合,足以在实现大容量+持久内存配置的同时,与多种面向英特尔® 架构优化的AI框架和软件工具一起将AI推理的性能提升到足以满足主流应用需求的水准。

而且再考虑到单台服务器在大大扩展内存容量后可能会大幅减少服务器用量的收益,这其实不仅会省去一些采购成本、管理成本和人力成本,在节能降耗、打造绿色数据中心方面,其实也是有一些潜在机会的。

了解更多内容,请点击阅读原文。