环境:

scala:2.12.10

spark:3.0.3

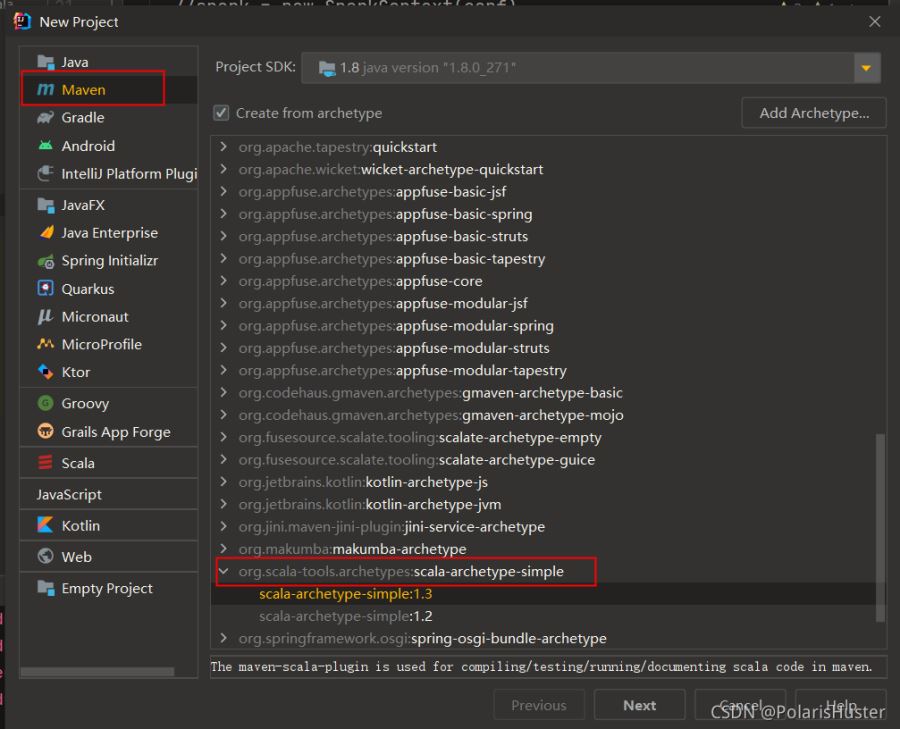

1、创建scala maven项目,如下图所示:

2、

2、

不同版本scala编译参数可能略有不同,笔者使用的scala版本是2.12.10,scala-archetype-simple插件生成的pom文件

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

<plugin> <groupid>org.scala-tools</groupid> <artifactid>maven-scala-plugin</artifactid> <version>2.15.0</version> <executions> <execution> <goals> <goal>compile</goal> <goal>testcompile</goal> </goals> <configuration> <args> <arg>-make:transitive</arg> <arg>-dependencyfile</arg> <arg>${project.build.directory}/.scala_dependencies</arg> </args> </configuration> </execution> </executions></plugin> |

要去除-make:transitive这个参数,否则会报错。

3、创建sparkpi object类

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

object sparkpi { def main(args: array[string]): unit = { val spark = sparksession .builder .appname("spark pi") .master("spark://172.21.212.114:7077") .config("spark.jars","e:\\work\\polaris\\polaris-spark\\spark-scala\\target\\spark-scala-1.0.0.jar") .config("spark.executor.memory","2g") .config("spark.cores.max","2") .config("spark.driver.host", "172.21.58.28") .config("spark.driver.port", "9089") .getorcreate() //spark = new sparkcontext(conf). val slices = if (args.length > 0) args(0).toint else 2 val n = math.min(100000l * slices, int.maxvalue).toint // avoid overflow val count = spark.sparkcontext.parallelize(1 until n, slices).map { i => val x = random * 2 - 1 val y = random * 2 - 1 if (x*x + y*y <= 1) 1 else 0 }.reduce(_ + _) println(s"pi is roughly ${4.0 * count / (n - 1)}") spark.stop() }} |

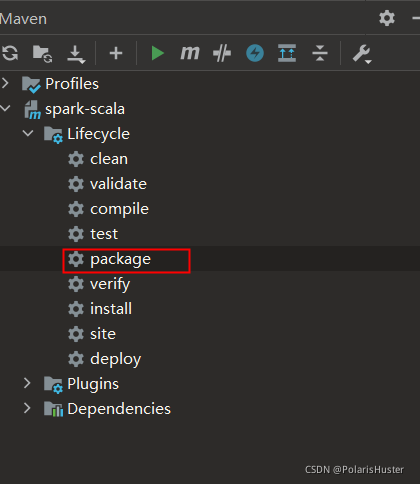

4、执行打包命令:

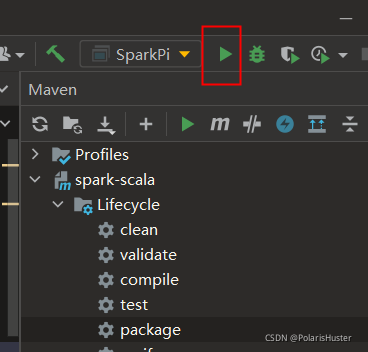

5、点击idea run执行即可:

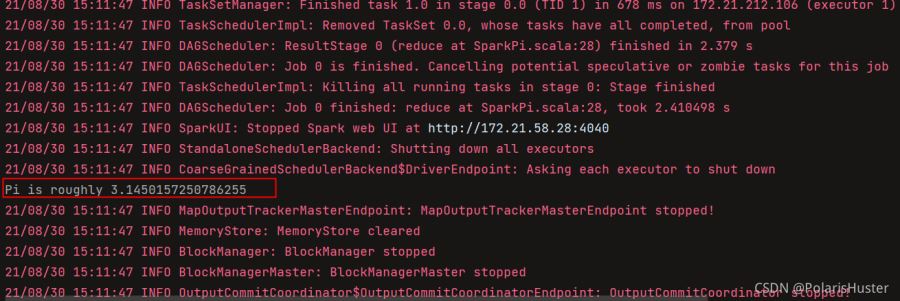

6、结果如下所示:

ps:

1、创建sparksession时需要指定idea所在机器ip地址,因为默认会把spark driver所在机器域名发送过去,导致无法解析(在spark 服务器上配置idea所在机器域名也可以,但是这样太不灵活)

2、spark-3.0.3默认使用的scala版本是2.12.10,所以要注意idea使用scala版本,否则会出现serailizableid不一致的兼容问题

到此这篇关于idea创建spark maven项目并连接远程spark集群的文章就介绍到这了,更多相关idea spark集群内容请搜索服务器之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持服务器之家!

原文链接:https://blog.csdn.net/john1337/article/details/119995531